Kenalan dengan Ollama! Unggul Mana dari Hugging Face?

Apa itu Ollama, dan apakah Ollama lebih unggul dari Hugging Face? Pertanyaan ini makin sering muncul di kalangan developer AI yang ingin mengeksplorasi alternatif model bahasa besar (Large Language Model/LLM) di luar ekosistem cloud. Artikel ini akan membantumu mengenal Ollama lebih dalam dan membandingkannya langsung dengan Hugging Face.

Apa Itu Ollama?

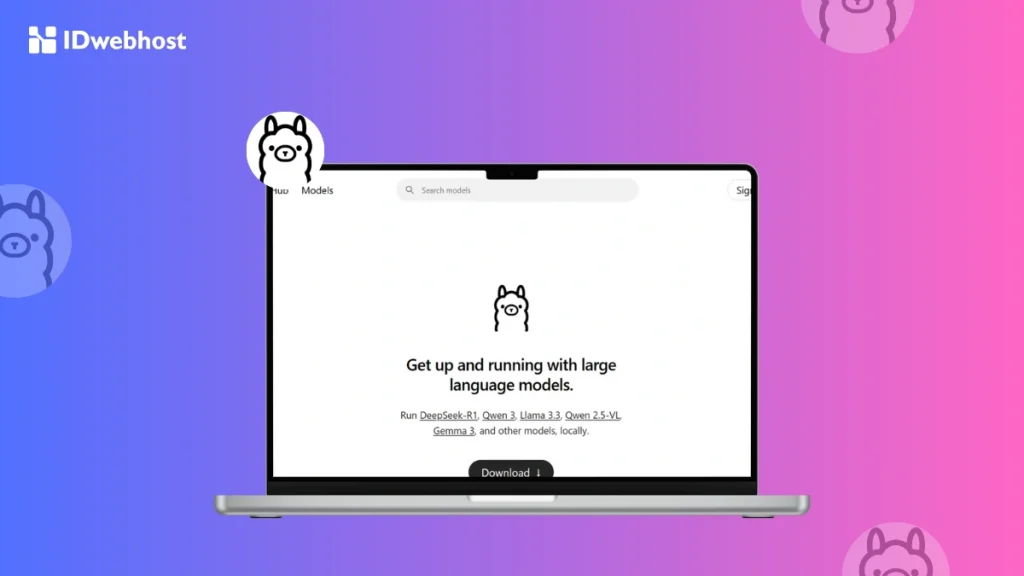

Ollama adalah alat open-source yang memungkinkan kamu menjalankan Large Language Model (LLM) langsung di perangkat lokal.

Berbeda dengan solusi AI berbasis cloud, Ollama dirancang untuk memberikan kendali penuh atas data dan performa model, tanpa bergantung pada server eksternal.

Baca Juga: Cara Menggunakan Hugging Face: Apa Saja Fitur & Manfaatnya?

Buat kamu yang bekerja sebagai developer AI, peneliti, atau bahkan pelaku bisnis yang sangat memperhatikan privasi data, Ollama bisa menjadi jawaban.

Karena semua proses dijalankan secara lokal, data kamu tidak perlu “jalan-jalan” ke cloud, sehingga risiko kebocoran data jauh lebih kecil. Selain itu, proses lokal juga meminimalisir latensi dan meningkatkan keandalan sistem.

Baca Juga: Framework AI Populer 2025: TensorFlow, PyTorch & Lainnya

Cara Kerja Ollama

Secara teknis, Ollama menciptakan lingkungan terisolasi di dalam sistem kamu. Tujuannya adalah untuk memastikan proses eksekusi model AI berjalan stabil, tanpa bentrok dengan software lain yang sudah terinstal. Di dalam lingkungan ini, sudah disiapkan komponen-komponen penting, yaitu:

- Model weights: Bobot yang sudah dilatih sebelumnya untuk memahami dan merespons input pengguna.

- Configuration files: Berisi pengaturan detail yang menentukan cara model bekerja di setiap sesi.

- Dependencies: Library dan alat pendukung seperti tokenizer atau runtime, yang dibutuhkan agar model bisa dijalankan tanpa error.

Langkah penggunaannya pun cukup simpel. Pertama, kamu tinggal menarik model dari pustaka Ollama. Setelah itu, kamu bisa menjalankan model tersebut langsung atau menyesuaikannya sesuai kebutuhan proyek.

Proses interaksi kamu dengan Ollama adalah berbasis prompt, di mana kamu perlu mengetikkan perintah dan model akan merespons.

Agar performanya optimal, Ollama disarankan dijalankan di sistem dengan dedicated GPU, seperti NVIDIA atau AMD.

Meskipun bisa juga dijalankan di sistem dengan GPU terintegrasi, hasilnya mungkin tidak semulus penggunaan GPU khusus. Kamu bisa mengecek kompatibilitas GPU di halaman resmi GitHub Ollama.

Fitur Utama Ollama

Lalu, apa saja yang membuat Ollama menarik dibandingkan platform lainnya, bahkan lebih unggul dari Hugging Face? Berikut fitur-fitur kuncinya:

Local AI Model Management

Kamu bisa mengelola model AI sepenuhnya dari lokal. Mulai dari mengunduh, memperbarui, hingga menghapus model, semua bisa dilakukan dengan mudah.

Bahkan, kamu juga bisa mengatur versi model yang berbeda—fitur yang sangat berguna untuk riset atau pengujian versi model tertentu.

Command Line & GUI Support

Secara default, Ollama bekerja lewat command-line interface (CLI)—tepat untuk kamu yang terbiasa menggunakan terminal.

Tetapi, Ollama juga kompatibel dengan berbagai GUI pihak ketiga seperti Open WebUI. Jadi, kalau kamu lebih nyaman dengan tampilan visual, opsi ini tetap terbuka.

Multi-Platform Support

Ollama mendukung sistem operasi macOS, Linux, dan Windows (meski versi Windows masih dalam tahap preview).

Bahkan, karena mendukung Linux, kamu bisa juga menginstal Ollama di VPS. Ini membuka peluang untuk kolaborasi tim atau proyek berskala lebih besar tanpa perlu perangkat keras mahal.

Manfaat Menggunakan Ollama

Ada sejumlah manfaat nyata dari penggunaan Ollama, terutama jika dibandingkan dengan solusi cloud seperti Hugging Face:

- Privasi & Keamanan Data: Semua proses dijalankan secara lokal, jadi data sensitif tidak meninggalkan perangkat kamu.

- Bebas Ketergantungan Cloud: Kamu tidak perlu khawatir tentang koneksi internet atau layanan cloud yang bisa saja berubah kebijakan.

- Fleksibilitas Kustomisasi: Ollama memungkinkan kamu menyesuaikan model sesuai kebutuhan, cocok untuk riset atau proyek niche.

- Akses Offline: Kamu bisa tetap bekerja meskipun tidak terhubung ke internet—penting untuk proyek di wilayah dengan koneksi terbatas.

- Efisiensi Biaya: Tidak ada biaya langganan atau biaya transfer data seperti pada layanan cloud. Sekali investasi di perangkat keras, kamu bisa menjalankan model sesering mungkin.

Apa Keunggulan Ollama dari Hugging Face?

Sekarang saatnya membandingkan Ollama dengan Hugging Face secara langsung. Hugging Face adalah salah satu platform AI berbasis cloud paling populer, tapi bukan berarti selalu lebih baik. Yuk, lihat perbandingannya Ollama vs Hugging Face:

| Aspek | Ollama | Hugging Face |

| Instalasi & Penggunaan | Setup lokal; perlu konfigurasi awal | API siap pakai; lebih cepat digunakan |

| Skalabilitas | Tergantung hardware lokal | Tidak terbatas (berbasis cloud) |

| Privasi | Data tetap lokal | Data diproses di cloud |

| Latensi | Sangat rendah | Bergantung pada koneksi |

| Biaya | Sekali bayar hardware | Bayar per penggunaan cloud |

Buat kamu yang mengutamakan privasi dan kecepatan respons, keunggulan Ollama dari Hugging Face cukup jelas. Namun jika proyek kamu butuh sumber daya besar dan skalabilitas tinggi, Hugging Face masih relevan, terutama untuk deployment skala enterprise.

Menariknya, Ollama juga bisa menjalankan model GGUF dari Hugging Face Hub. Jadi kamu tetap bisa menikmati model unggulan dari Hugging Face, tapi menjalankannya secara lokal—kombinasi yang cukup fleksibel.

Contoh Aplikasi Ollama

Masih bingung bagaimana menggunakan Ollama dalam proyek nyata? Berikut beberapa contoh aplikasi Ollama:

Chatbot Lokal

Kamu bisa membuat chatbot cerdas dan responsif tanpa perlu internet. Cocok untuk layanan pelanggan di sektor seperti transportasi, pendidikan, atau pemerintahan—di mana latensi rendah dan privasi tinggi menjadi prioritas.

Riset Akademik

Ollama mendukung riset machine learning secara offline, yang cocok untuk universitas atau lembaga riset di daerah dengan keterbatasan koneksi. Tim bisa mengembangkan model berdasarkan data sensitif tanpa risiko kebocoran.

Aplikasi AI Berbasis Privasi

Perusahaan hukum, layanan kesehatan, atau keuangan bisa membuat aplikasi AI yang sepenuhnya lokal. Misalnya, software analisis kontrak, asisten medis otomatis, atau alat pemrosesan dokumen legal.

Integrasi ke Platform yang Sudah Ada

Ollama bisa diintegrasikan ke sistem yang sudah kamu miliki. Misalnya: CMS untuk konten, CRM untuk manajemen pelanggan, atau platform internal perusahaan.

Kesimpulan

Ollama menawarkan pendekatan baru dalam menjalankan model AI, dengan penekanan pada kendali lokal, privasi, dan efisiensi biaya.

Jika dibandingkan dengan Hugging Face, Ollama unggul di aspek kustomisasi, kecepatan, dan keamanan data, meski kalah dalam skalabilitas.

Buat kamu yang sedang membangun proyek AI dan ingin mencoba Ollama, solusi VPS Murah dari IDwebhost bisa jadi pilihan tepat.

Dengan dukungan sistem operasi Linux dan performa stabil, kamu bisa menjalankan Ollama secara remote tanpa perlu investasi perangkat mahal.

Cocok untuk developer AI yang butuh fleksibilitas dan efisiensi!