Cara Memperbaiki “indexed, though blocked by robots.txt”

“indexed, though blocked by robots.txt” menjadi masalah serius pada website Anda jika tidak segera diatasi. Hal ini karena dapat mempengaruhi pada halaman-halaman website Anda menjadi masalah dalam proses pengindeksan di mesin pencari.

Untuk itu, sebelumnya mari kita cek terlebih dahulu sumber masalahnya dsb.

Contents

Apa itu Robots.txt ?

Robots.txt adalah sebuah file yang berisi kumpulan instruksi-instruksi dalam menjalankan bot mesin pencari atau mudahnya menunjukan jalan kepada mesin pencari agar website yang dimiliki dapat terindeks di mesin pencari.

Jadi, robots.txt ini memberikan tanda yang terdapat pada website agar robots.txt menunjukan jalannya agar tersampaikan ke mesin pencari.

Mengapa Robots.txt Penting?

Ketika membangun website baru dan dihubungkan dengan Google Webmaster Tool, dari sini Google akan melakukan proses crawling atau perayapan yang bertujuan website baru tsb dapat muncul di hasil pencarian.Selain itu, ada juga juga proses pendataan yang dilakukan oleh Google dengan kata kunci yang ada website tsb dsb.

Robots.txt juga dapat melakukan pemisahan halaman yang tidak ingin Anda tampilkan ke dalam mesin pencari. Contohnya, jika website Anda memiliki halaman member yang dimana informasi pada halaman tsb merupakan privasi dan hanya member saja yang diperbolehkan mengaksesnya, maka Anda dapat melakukan filter pada halaman member ini agar tidak di crawl atau tidak dirayapi demi menjaga privasi halaman tsb. Jadi, walaupun Anda tidak menggunakan robots.txt Google tetap akan melakukan proses ‘crawl’ sampai dengan keseluruhan halaman yang ada di website.

Selain fungsi dari robots.txt yang dapat membantu menghalangi mesin pencari untuk tidak melakukan crawl situs, robots txt juga dapat mengurangi beban yang harus diterima oleh halaman website tsb.

Cara Memperbaiki “Indexed though blocked by robots.txt”

Pesan “Indexed through blocked by robots.txt” muncul di Google Search Console (GSC) saat Google telah mengindeks URL yang tidak diizinkan untuk di proses crawling.

Dalam kondisi tertentu, error seperti ini akan menjadi masalah langsung ketika Anda memblokir crawling di file robots.txt Anda.

Jadi untuk mengatasi pesan error seperti ini, Anda perlu melakukan proses pemecahan masalah seperti berikut untuk memperbaikinya.

Jika Anda tidak ingin URL di Index

Anda dapat menambahkan tag meta robot noindex dan pastikan untuk mengizinkan perayapan. Jika Anda memblokir halaman agar tidak ingin dirayapi, Google mungkin masih dapat mengindeksnya karena perayapan dan pengindeksan adalah dua hal yang berbeda. Jika Google dapat melakukan crawl atau perayapan pada suatu halaman website, maka Google tidak dapat meninjau dari tag meta noindex dan masih memiliki potensi untuk mengindeks halaman website tsb karena masih memiliki link-link website.

Jika URL di kanokalisasi atau di optimasi dari banyaknya URL yang dimiliki untuk menunjuk ke halaman website tertentu, maka tidak menambahkan tag meta robot noindex adalah solusi yang tepat untuk Anda lakukan.

Jika Anda ingin URL di Index

Anda perlu mencari tahu mengapa Google tidak dapat merayapi URL dan memeriksa apa yang menghalangi atau memblokirnya kemudian Anda perlu untuk menghapusnya.

Penyebab yang memungkinkan hal tsb terjadi adalah karena adanya pemblokiran perayapan di robots.txt. Namun ada beberapa skenario lain di mana Anda mungkin melihat pesan yang mengatakan bahwa Anda diblokir.

Untuk itu Anda perlu memastikan seperti hal-hal dibawah ini untuk mencari tahu kendalanya.

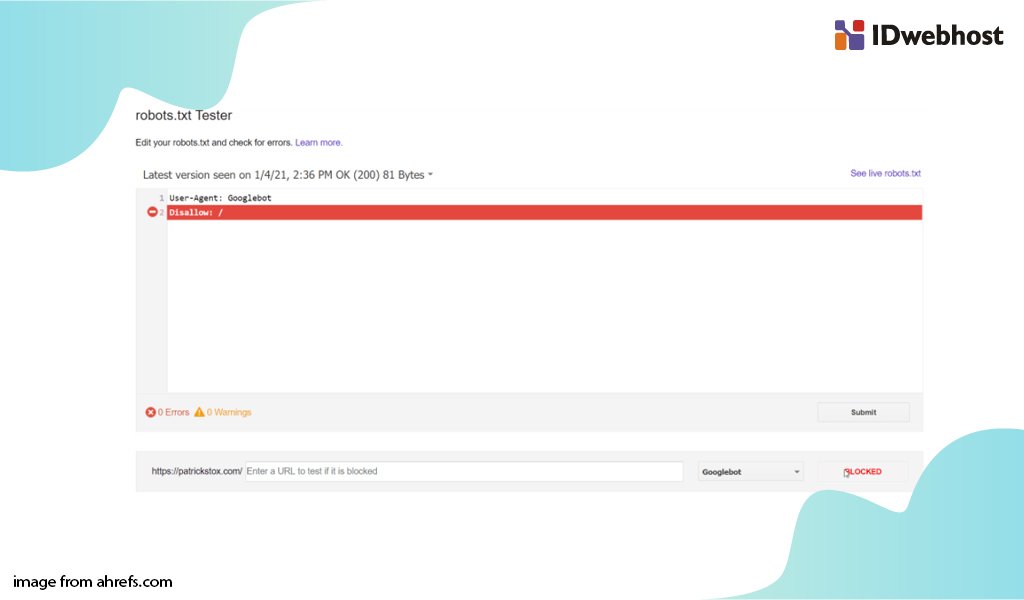

Cek Crawl Block di Robots.txt

Cara termudah untuk melihat masalah ini adalah dengan memeriksa robots.txt tester di Google Search Console yang akan menunjukan tanda aturan dalam pemblokiran.

Jika Anda tidak memiliki akses ke Google Search Console, Anda dapat membukanya dengan cara menuliskan namadomainanda.com/robots.txt untuk menemukan file tsb.

Jika Anda menemukan hal seperti ini :

Disallow : /

Mungkin Anda dapat memeriksa pada bagian user-agent pada website Anda yang memblokir semua orang,

User-agent : *

Disallow : /

Bagaimana cara memperbaikinya ?

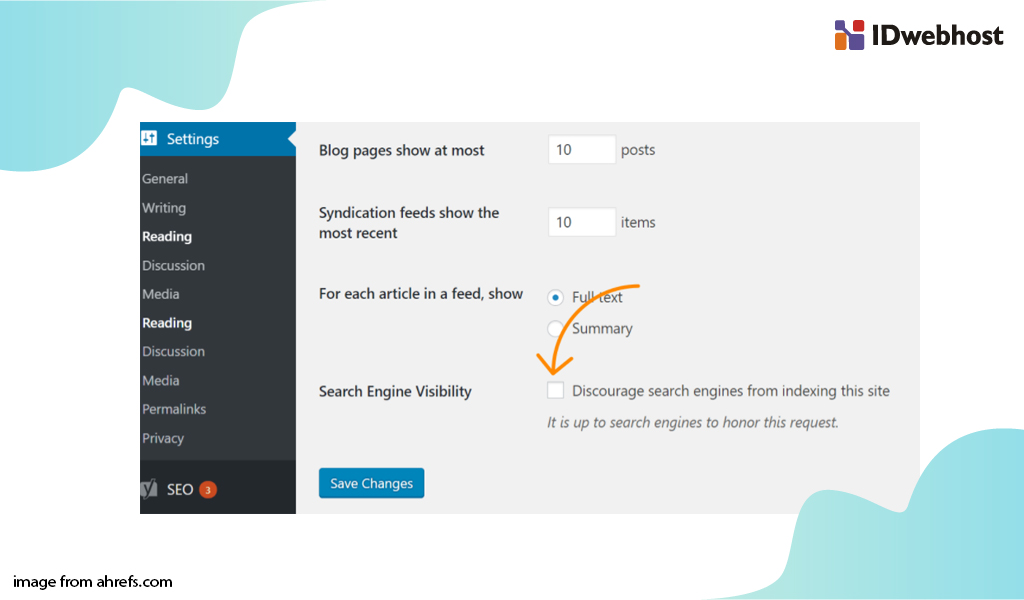

Anda dapat menghapus pesan “disallow” yang menyebabkan pemblokiran. Contohnya jika di website WordPress maka Anda dapat melakukan perbaikan dengan cara :

- Klik “Settings”

- Klik “Reading”

- Pastikan “Search Engine Visibility” pada posisi “unchecked”.

Cek Intermittent Blocks

Masalah intermittent Blocks bisa menjadi sulit untuk dipecahkan. Intermittent Blocks adalah permasalahan yang dikarenakan kondisi blocking karena suatu hal yang belum bisa dipastikan.

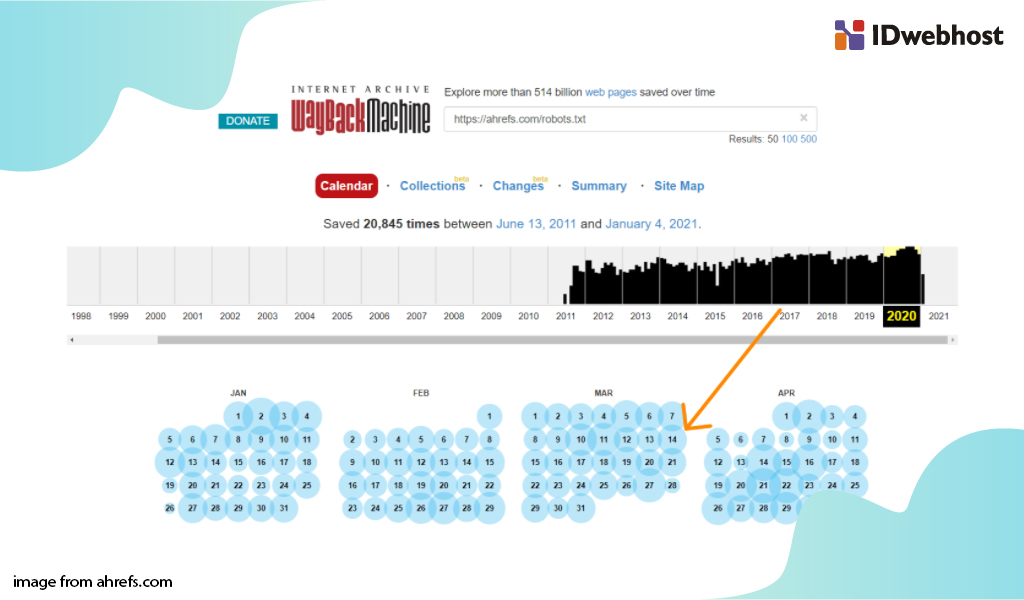

Untuk itu, langkah yang bisa Anda lakukan adalah dengan memeriksa riwayat file robots.txt Anda. Misalnya di bagian robots.txt tester, Anda dapat melihat versi file sebelumnya yang dapat Anda klik dan lihat isinya.

Jika Anda klik dropdown, Anda dapat melihat versi file sebelumnya yang dapat Anda klik dan lihat isinya.

Anda pun juga dapat melakukan melalui the wayback machine dari archive.org juga memiliki riwayat file robots.txt untuk mengetahui website yang telah dirayapi. Anda dapat melakukan klik pada salah satu tanggal yang tersedia dan melihat file yang tersedia di tanggal tsb.

Bagaimana cara memperbaikinya ?

Solusi untuk memperbaiki intermittent blocks adalah bergantung pada apa yang menyebabkan masalah tsb. Misalnya, penyebabnya karena cache. Ketika cache saat dalam kondisi pengujian aktif, file robots txt mungkin menyertakan perintah pemblokiran. Dan saat cache dalam mode pengujian aktif, website tsb mungkin sudah terlihat dapat dirayapi atau crawlable. Dalam kasus ini, Anda dapat melakukan exclude .txt dari cache mode pengujian.

Cek User-agent Block

User-agent blocks adalah kondisi ketika website memblokir user-agent tsb seperti halnya yang dilakukan oleh Googlebot. Artinya, website tsb mendeteksi bot tertentu dan memblokir user-agentnya.

Jika Anda melihat halaman website dalam kondisi baik-baik saja di browser tetapi diblokir setelah mengubah pada bagian user-agent, artinya halaman website tsb telah Anda set sebagai halaman untuk diblokir.

Anda dapat menentukan user-agent dengan bantuan Chrome devtools. Pilihan lainnya adalah dengan menggunakan ekstensi browser untuk mengubah user-agent seperti ini.

Bagaimana cara memperbaikinya ?

Terdapat berbagai aspek yang memblokir hal ini karena bot, dari .htaccess, konfigurasi server, firewall, CDN, atau bahkan sesuatu yang mungkin tidak dapat Anda lihat dan terkontrol oleh penyedia layanan hosting Anda.

Jadi solusinya adalah Anda dapat menghubungi penyedia layanan hosting atau jika Anda menggunakan CDN, Anda dapat dapat bertanya darimana block tsb berasal dan cara mengatasinya.

Contohnya seperti dua cara berbeda ini dalam memblokir user-agent di ht.access yang perlu Anda cari :

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} Googlebot [NC]RewriteRule .* – [F,L]

Atau

BrowserMatchNoCase “Googlebot” bots

Order Allow,Deny

Allow from ALL

Deny from env=bots

Kesimpulan

Itulah cara dalam mengatasi “indexed, though blocked by robots.txt” yang Anda dapat coba.

Semoga panduan yang tertuang pada artikel ini dapat memberikan gambaran kepada Anda tentang bagaimana menangani dan memberikan solusi dalam permasalahan “indexed, though blocked by robots.txt”.

Kemudian agar Anda tidak ketinggalan informasi seputar bisnis, Anda dapat terus keep update informasi di blog IDwebhost.

Selain itu jika Anda membutuhkan layanan web hosting dan domain, Anda dapat menghubungi IDwebhost. Karena IDwebhost memberikan promo tiap harinya. Salam!

Member since 2 Jul 2013